Faux positif, vrai positif, faux négatif, vrai négatif

#7 Ou comment ne plus se mélanger les pinceaux.

Bonjour tout le monde ! 👋🏻

Si vous êtes en reconversion en data science, vous allez vite croiser les algorithmes de classification.

Dans cette 7ème édition, grâce à Léo, qui a grandi depuis l’histoire des haricots, nous allons démêler le nœud entre faux positif, vrai positif, faux négatif et vrai négatif.

C’est parti !

Léo avait tout donné…

👦🏻 Léo n’est pas très bon en maths, mais pour le prochain contrôle, il est décidé à réussir. Il sait ce qu’il doit faire : demande à sa sœur Lucie 👧🏻 de l’aider à réviser. Si vous avez suivi leur histoire sur Linkedin, vous savez que Lucie a de quoi lui en vouloir. Pourtant, dans sa magnanimité, elle a tout de même aidé son frère, et l’a fait travailler tous les jours jusqu’à son contrôle.

Léo passe l’examen et se sent confiant.

Aujourd’hui, lundi 9h, son prof, M. Pacoule 👨🏻, rend les devoirs. Léo est stressé. Il y a mis tant d’efforts, il espère avoir au moins 15/20.

Le prof s’approchant de Léo, ne laisse rien transparaître sur son visage.

C’est mauvais signe.

“Léo, je t’aurai bien mis 18/20, mais comme il est évident que tu as triché, un beau 0 fera l’affaire. Et que je ne t’y reprenne plus !”

C’est la douche froide !

L’étudiant rentre tout penaud chez lui, et montre à ses parents son devoir estampillé d’un “TRICHE” rouge vif.

Que s’est-il passé ?

Petite pause blabla 😇

Je suis en train de faire des ajouts et amélioration à Parcours Maths (mon programme de mise à niveau en maths pour les personnes en reconversion dans la data),

Tous les inscrits auront accès à toutes les mises à jour gratuitement.

Mais une fois que j’aurai amélioré le parcours, au point d’en faire une V2, alors le prix va augmenter.

C’est donc la dernière fois que vous pouvez avoir accès au Parcours à moins de 200€ avec le code promo “DATA” et ce, jusqu’au 10 octobre. 😉

C’est par ici → Parcours Maths

Voilà c’est tout ! On revient à Léo.

M. Pacoule est-il un robot ?

Revenons en arrière.

Nous sommes samedi, et M. Pacoule travaille consciencieusement à son bureau. Il corrige les devoirs de la classe de Léo.

Il arrive justement à sa copie. Il aime bien le petit Léo, mais il ne fait clairement pas assez d’efforts et ses notes restent médiocres.

Première question, c’est bon !

La deuxième aussi.

”Tiens Léo aurait-il travaillé ? Il va peut-être bien avoir la moyenne cette fois-ci.”

M. Pacoule fronce les sourcils au fur et à mesure qu’il avance dans la correction.

La copie est presque parfaite ! Juste deux erreurs d’inattention. Très étonnant.

Même trop étonnant venant de la part de Léo.

Son radar à triche se met à sonner : “ Léo a triché, ce n’est pas possible autrement !”

Pourquoi je vous raconte cette histoire ?

Quel est le rapport avec vrai positif, faux positif, vrai négatif et faux négatif ?

Ces quatre expressions sont les différents résultats d'une prise de décision dans la situation où nous avons deux possibilités.

Et c’est le cas pour M.Pacoule qui doit décider si Léo a triché ou non.

Il aurait pu fonctionner comme un algorithme de classification entraîné grâce à de nombreuses copies labellisées “triche” ou “non triche”.

Parce qu’il a vu et appris tout au long de sa carrière, il pourrait classer facilement les copies en “triche” ou “non triche”.

Pour entraîner un algorithme de classification, il nous faut des données dont on connaît le label. Ici, il nous faudrait des copies dont on sait si l’élève a triché ou non. Ensuite, on coupe en deux notre jeu de donnée.

On va en fournir une bonne partie à l’algorithme pour qu’il apprenne et on en garde une autre partie pour le tester.

Ainsi, une fois son apprentissage fini, on lui donne la deuxième partie des données et il nous dira pour chaque copie quel est son label. Comme nous connaissons les labels de chaque donnée, nous pourrons analyser les résultats et voir si l’algorithme se trompe et comment.

Léo est victime d’un faux positif !

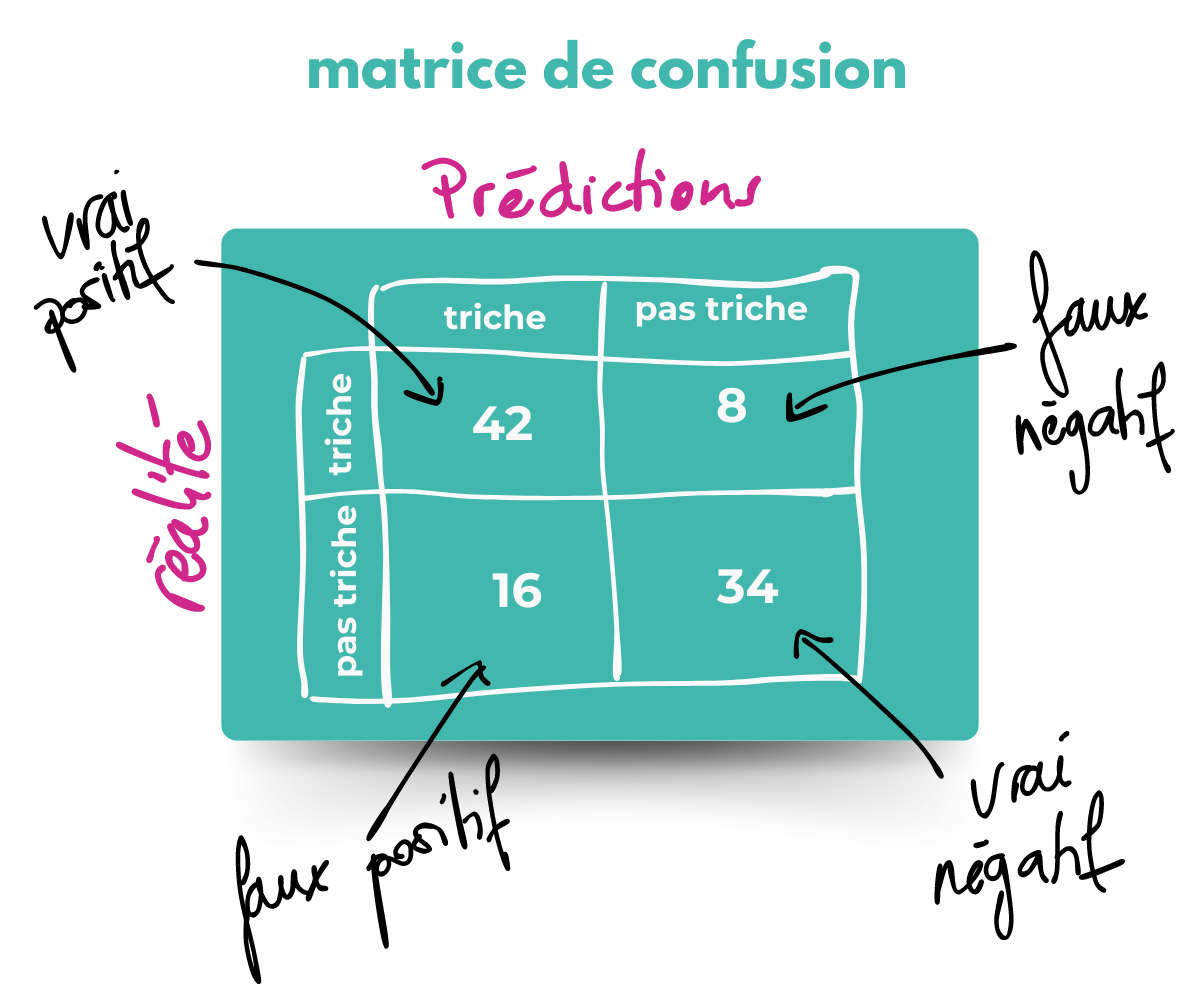

On peut obtenir une matrice de confusion avec tous les résultats du test donnés par l’algorithme.

D’après cette matrice de confusion, sur 100 élèves (1 élève = 1 copie) :

50 élèves ont triché (42 + 8 ) et 50 élèves (16 + 34) n’ont pas triché.

L’algorithme a classé comme “triche” 42 copies d’élèves sur les 50 tricheurs (vrais positifs : VP)

Il a classé comme “non triche” 34 copies d’élèves sur les 50 non tricheurs (vrais négatifs : VN).

Hélas, 16 élèves ont été classés comme tricheurs alors qu’ils n’avaient pas triché.

Ce sont les faux positifs (FP). Et la copie de Léo en fait partie. 😕

Remarque :

→ positif et négatif font référence aux résultats donnés par l’algorithme.

→ vrai ou faux font référence à la réalité.

M. Pacoule a fonctionné comme cet algorithme.

Nous allons regarder s’il porte bien son nom ?

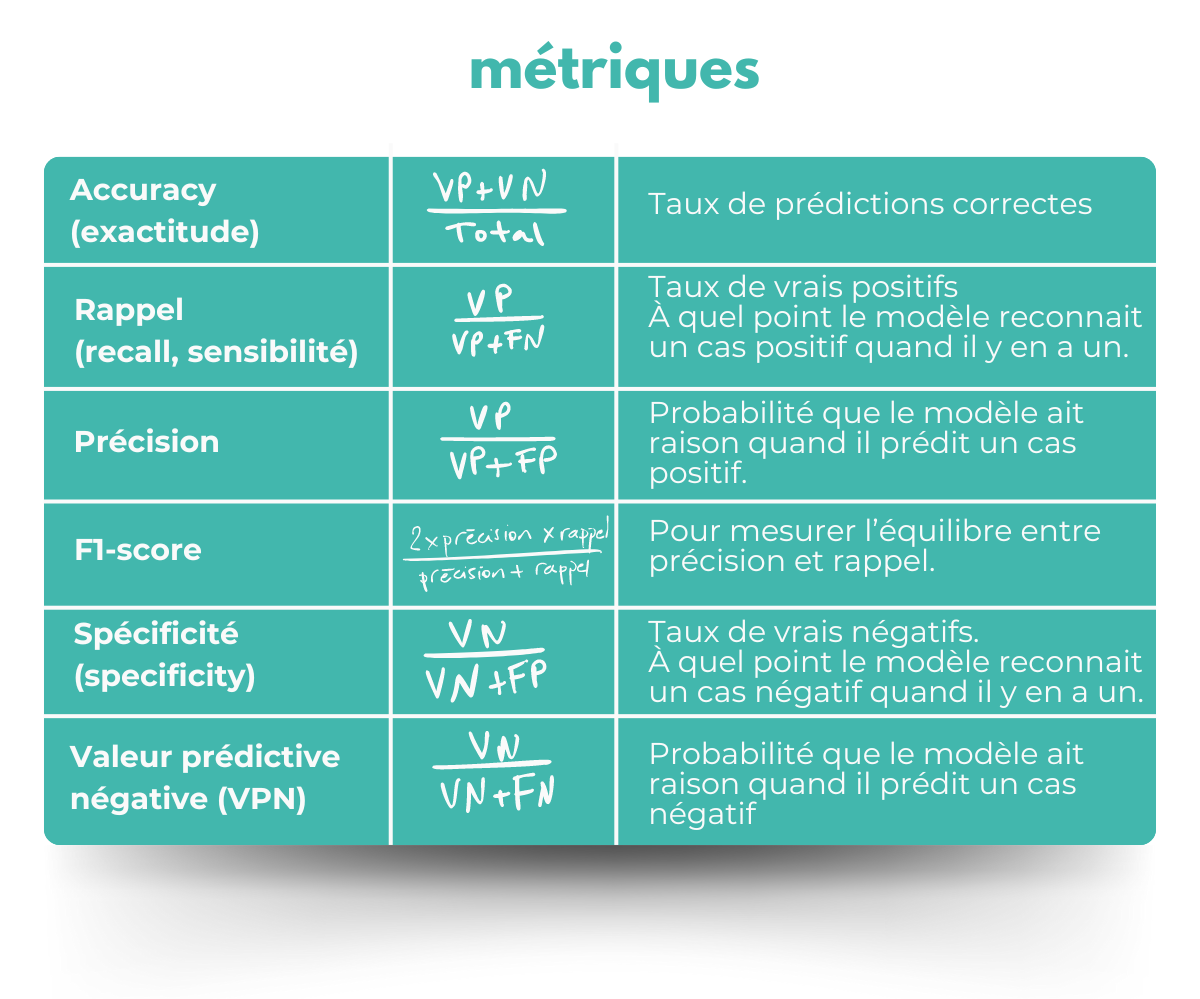

Pour comprendre un peu mieux les résultats, on peut utiliser plusieurs métriques.

(Pour rappel : VP = vrai positif, VN = vrai négatif, FP = faux positif, FN = faux négatif)

Chaque métrique nous apporte des informations sur l’efficacité du modèle ou dans notre histoire sur le jugement de M. Pacoule.

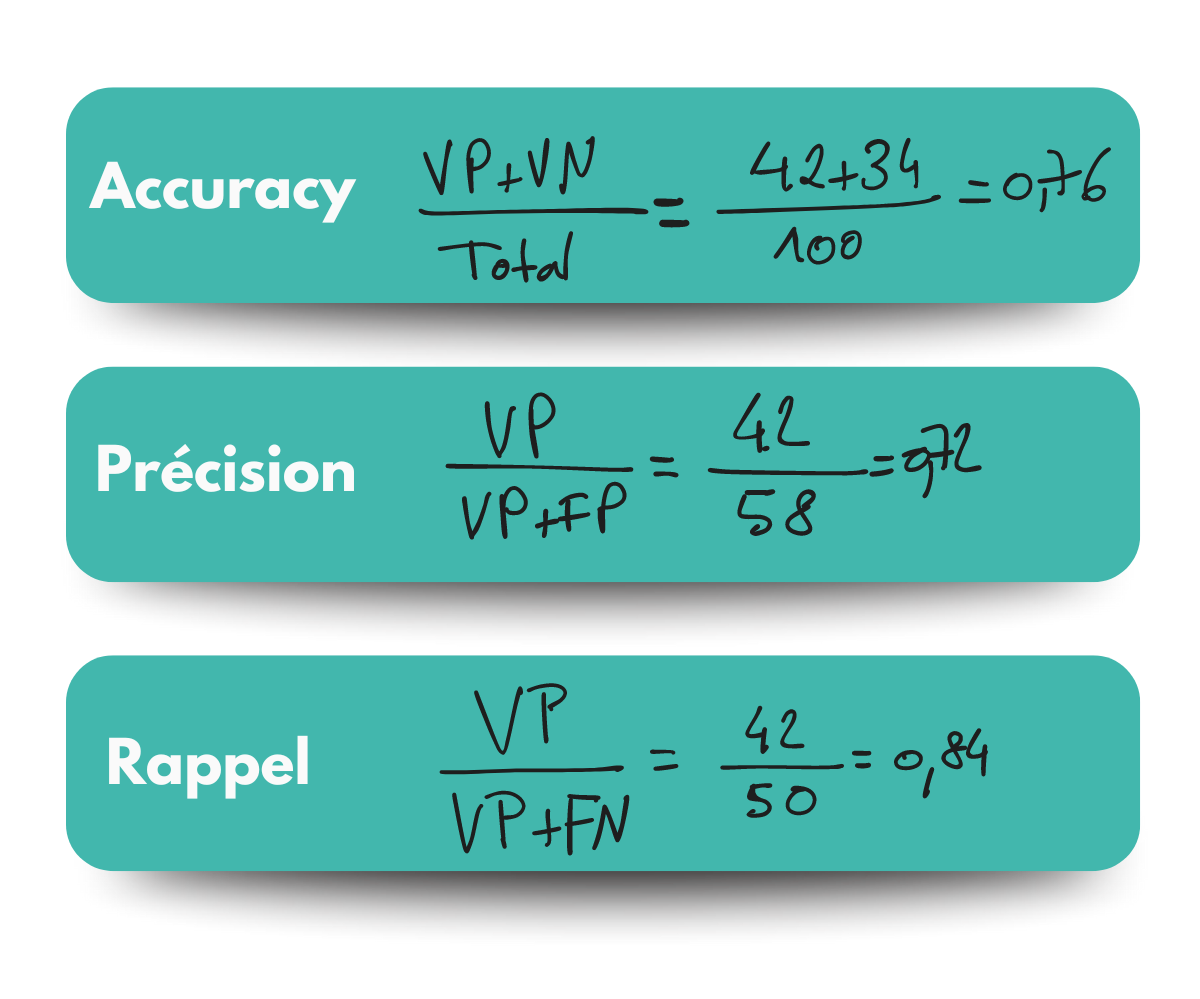

Faisons quelques calculs :

Si M. Pacoule fonctionne comme ce modèle :

Son jugement est correcte sur 76% des copies.

72% de ses accusations de triches sont justes (donc 28% sont fausses !)

Il détecte 84% des copies des tricheurs.

M. Pacoule est donc plutôt bon pour détecter les tricheurs mais il va tout de même accuser faussement 28% des élèves qui ne trichent pas, et ça c’est pas cool !

Léo en sait quelque chose.

Et si M.Pacoule avait fait un test statistique ?

Nous aurions pu aussi voir cela comme les résultats d’un test statistique. Mais je vous en parlerai dans la prochaine édition, vous en expliquant, ainsi, quelques notions. 😉

En attendant, on se retrouve sur LinkedIn et par curiosité : qui se rappelle du différent entre Léo et sa soeur Lucie ?